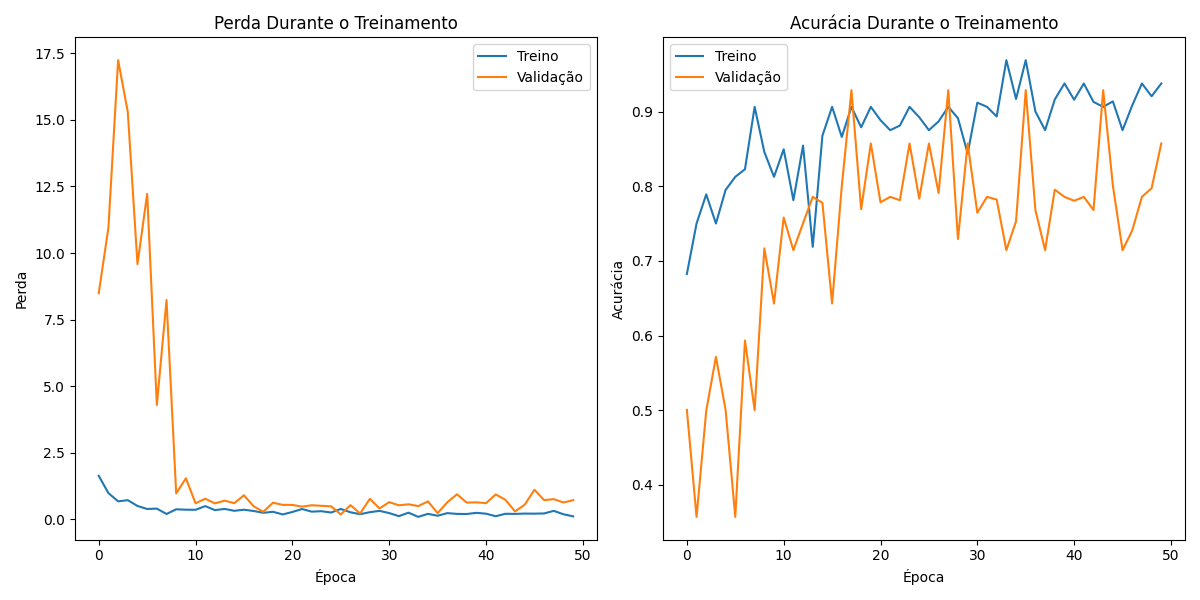

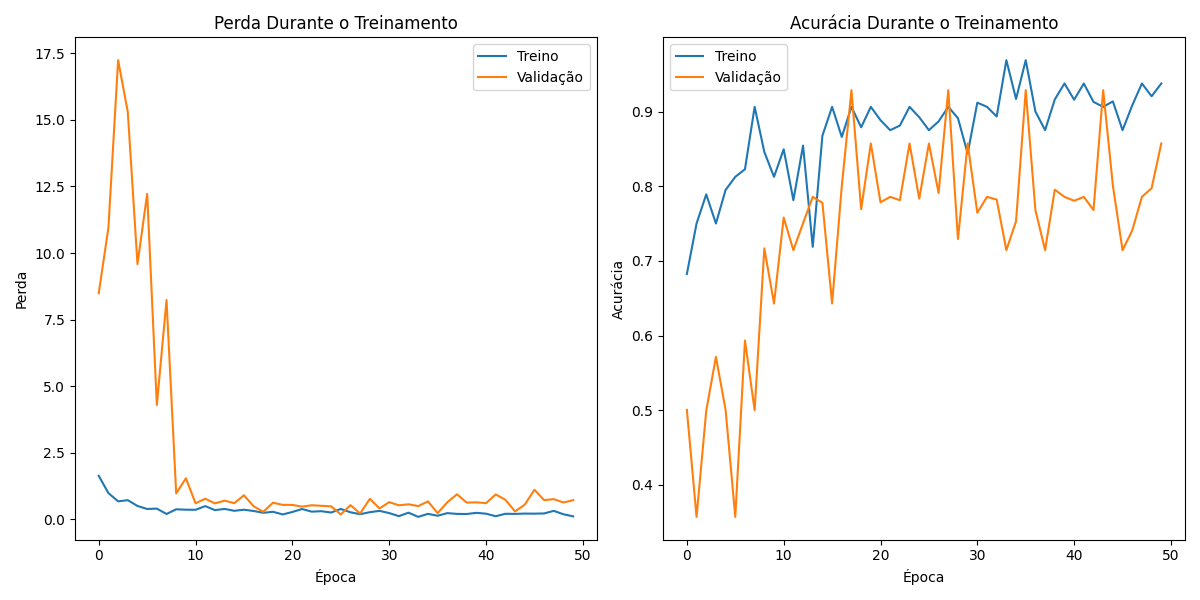

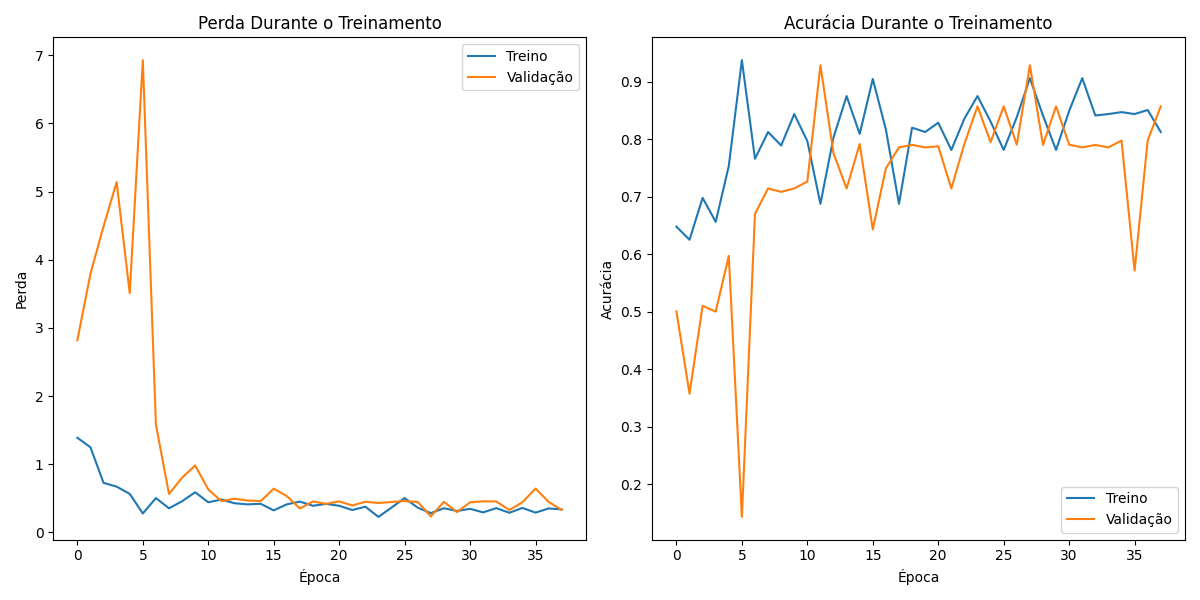

Perda: A linha azul (treinamento) mostra que o modelo errou cada vez menos nos dados que ele já conhecia. A linha laranja (validação) indica como o modelo se saiu em dados novos. Se as linhas se afastarem muito, significa que o modelo está decorando os dados de treinamento e não generalizando bem para novos dados (overfitting).

Acurácia: A linha azul mostra que o modelo acertou cada vez mais os dados de treinamento. A linha laranja mostra a acurácia em dados novos. Se as linhas se afastarem muito, também indica overfitting.

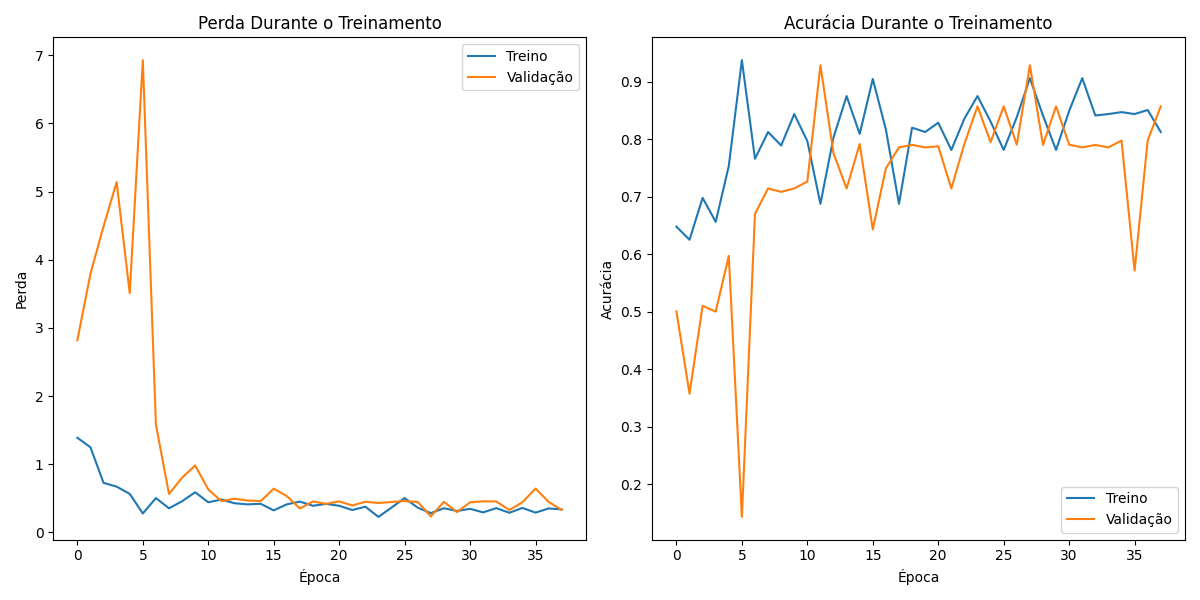

Modelo ajustado: Depois de algumas mudanças nos dados e ajustes nos parâmetros de treinamento, o modelo apresentou uma maior estabilidade na perda, especialmente na fase final do treinamento. Isso ocorreu devido a um ajuste mais fino dos hiper parâmetros e arquitetura mais robusta.

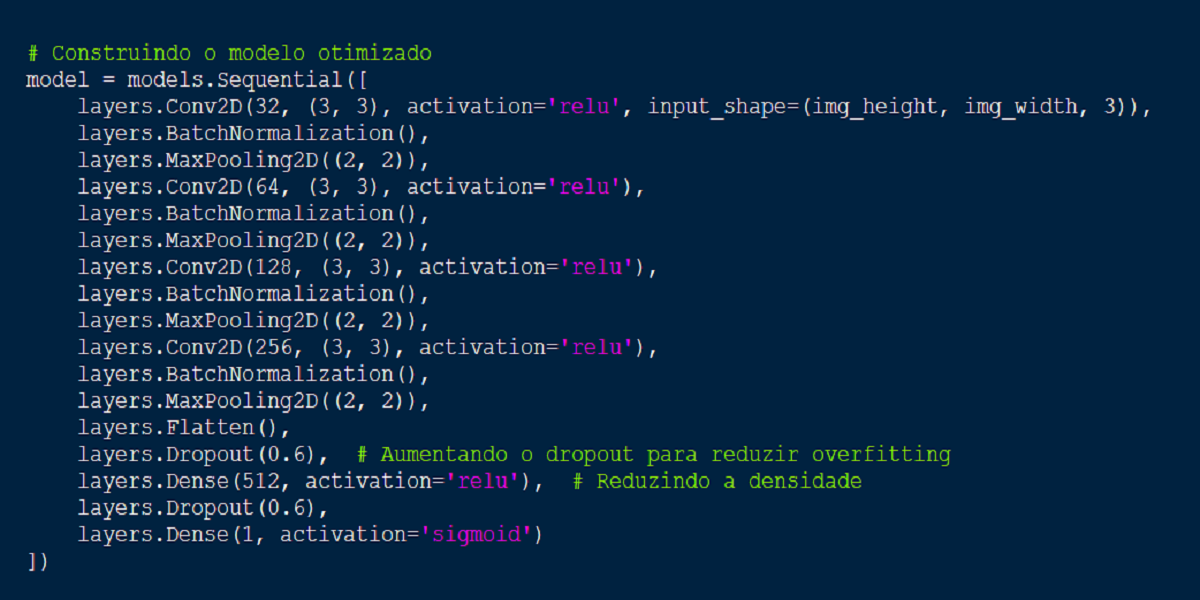

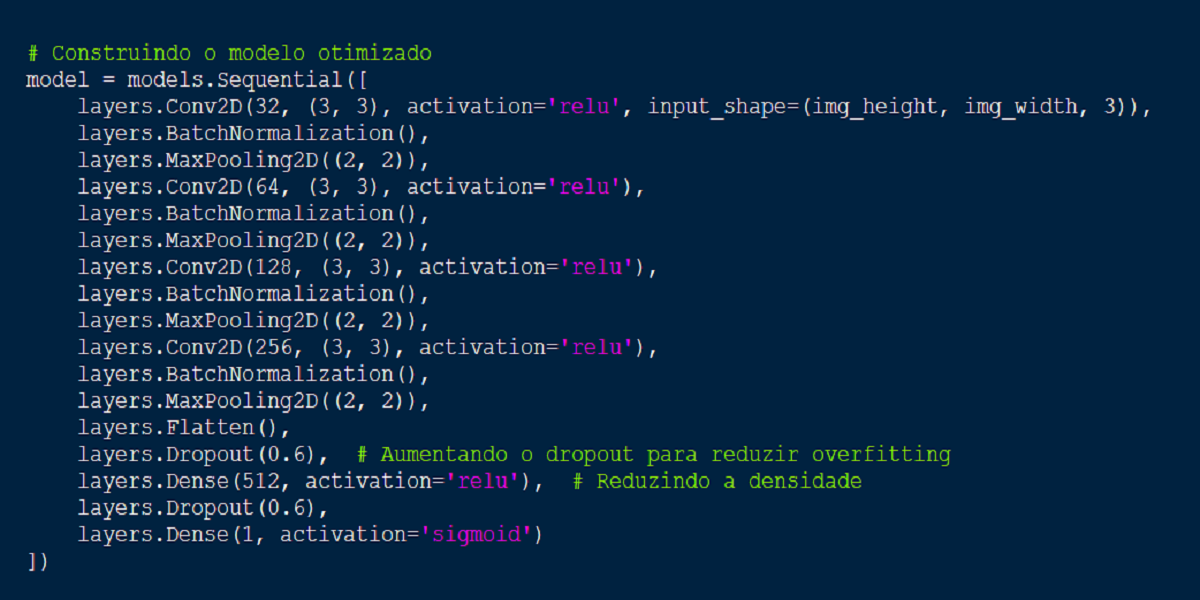

Estrutura e construção do modelo:

O que você está vendo nessa imagem é a estrutura da rede neural de aprendizado profundo (deep learning)

- models.Sequential: Essa linha cria um modelo sequencial, ou seja, as camadas são empilhadas uma após a outra.

- Conv2D: Camadas convolucionais aplicam filtros sobre as imagens de entrada para extrair características. Os parâmetros (32, (3,3), activation='relu') significam que são utilizados 32 filtros de tamanho 3x3 e a função de ativação é ReLU.

- BatchNormalization: Normaliza as ativações de cada camada para acelerar o treinamento e melhorar a estabilidade.

- MaxPooling2D: Reduz a dimensionalidade das representações, preservando as características mais importantes.

- Flatten: Achatamento da saída das camadas convolucionais para que possa ser conectada a uma camada densamente conectada.

- Dense:Camadas densamente conectadas, onde cada neurônio está conectado a todos os neurônios da camada anterior. A última camada Dense tem um único neurônio com ativação sigmoid, indicando que o modelo está sendo usado para uma tarefa de classificação binária (resultado 0 ou 1).

- Dropout: Regularização que desativa aleatoriamente um percentual de neurônios durante o treinamento, ajudando a prevenir overfitting.